輝達表示,預計由合作夥伴包括Cisco、Dell Technologies、Hewlett Packard Enterprise、Lenovo及美超微電腦(Supermicro)將推出基於Blackwell Ultra的伺服器;此外,Aivres、ASRock Rack、華碩、Eviden、鴻海、技嘉、英業達、和碩、廣達旗下雲達科技(QCT)、緯創及緯穎等公司也將參與其中。

輝達說明,包括北美大型雲端服務商Amazon Web Services、Google Cloud、Microsoft Azure及Oracle Cloud Infrastructure,與GPU雲服務商CoreWeave、Crusoe、Lambda、Nebius、Nscale、Yotta和YTL等也將是首批獲得Blackwell Ultra平台的公司。

NVIDIA GB300 NVL72連接72個Blackwell Ultra GPU和36個基於Arm Neoverse架構的NVIDIA Grace CPU,採用機架級設計,作為一個巨型GPU,專為推理階段擴展而設。通過GB300 NVL72,AI模型能夠利用平台的增強計算能力,探索不同的解決方案,將複雜的請求分解為多個步驟,從而提供更高品質的回應。

GB300 NVL72預計將在NVIDIA DGX Cloud上提供,這是一個端對端、全管理的AI平台,專為不斷演變的工作負載優化性能,並結合軟體、服務及AI專業知識。搭載DGX GB300系統的NVIDIA DGX SuperPOD使用GB300 NVL72機架設計。

NVIDIA HGX B300 NVL16相比於Hopper世代,提供11倍更快的推理性能、7倍更多計算資源與4倍更大的內存,為最複雜的工作負載(如AI推理)提供突破性性能。

Blackwell Ultra系統無縫整合了NVIDIA Spectrum-X以太網和NVIDIA Quantum-X800 InfiniBand平台,為每個GPU提供高達800 Gb/s的數據吞吐量,並通過NVIDIA ConnectX-8 SuperNIC實現遠端直接內存存取,幫助AI工廠和雲端數據中心處理AI推理模型,無需擔心瓶頸問題。

NVIDIA BlueField-3 DPU也被納入Blackwell Ultra系統中,支持多租戶網絡、GPU計算彈性、加速數據存取及即時網絡安全威脅檢測。

輝達表示,GB300 NVL72在使用DeepSeek-R1的AI模型可以每秒處理 1,000 個 Token ,使用 Hopper每秒處理 100 個 Token,代表GB300 NVL72可以使用10秒時間回答問題,但是Hopper要花費1.5分鐘。

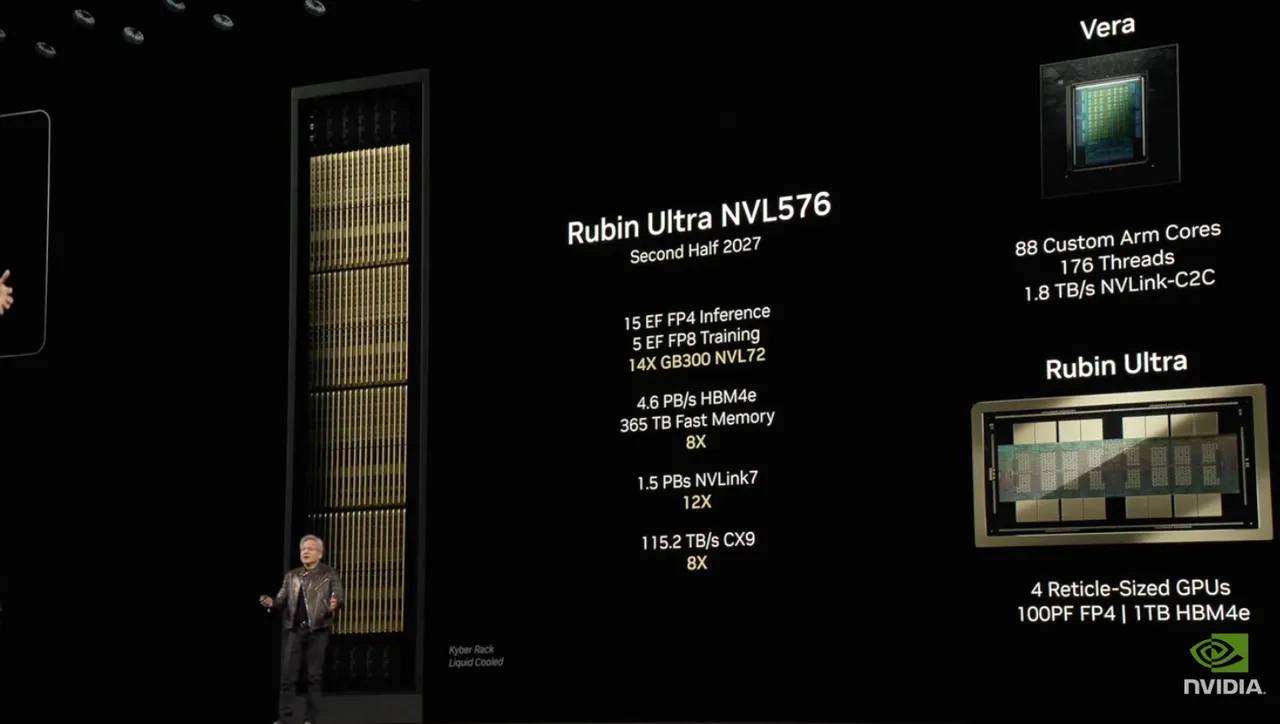

此外,黃仁勳也公布繼Hopper、Blackwell 之後的新一代GPU架構Rubin,以及搭配的CPU架構Vera。從資料圖來看,Vera Rubin採用288GB HBM4,從GB300 NVL72升至Vera Rubin NVL144,Vera記憶體是Grace的4.2 倍,記憶體頻寬將是Grace 的 2.4 倍,達88個CPU 核心,預計2026年下半年推出。黃仁勳也更進一步宣布,2027年下半年將推出Vera Rubin Ultra,由4個GPU整合而成,來到1TB HBM4e,且來到Rubin Ultra NVL576,聲稱性能是Hopper的900倍,相比之下,Blackwell則是Hopper的68倍。

點擊閱讀下一則新聞

點擊閱讀下一則新聞