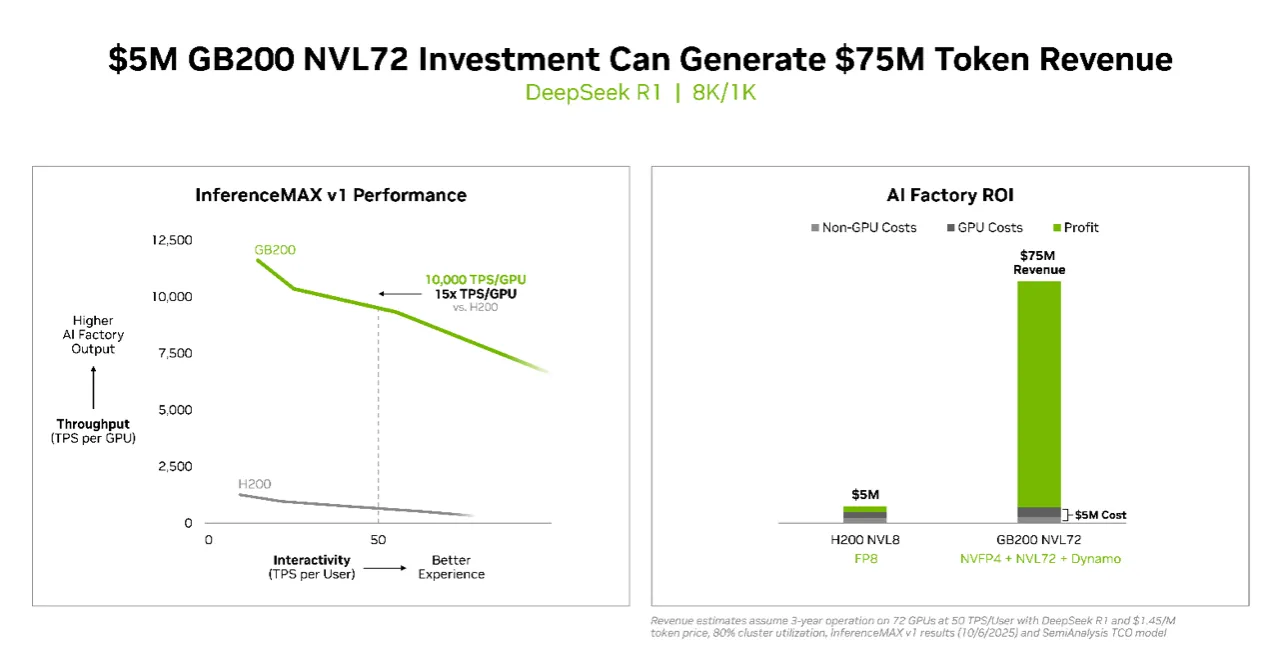

根據測試結果,投資500萬美元於 NVIDIA GB200 NVL72 系統,可創造高達7,500萬美元的詞元(token)收益,投資報酬率高達15倍,開啟推論運算的新經濟模式,也凸顯輝達在AI基礎設施領域的領先優勢。

Token為大型語言模型(LLM)處理文本的最小運算單位,是AI理解與生成語言的基本構成,每個token可能代表一個字、一個詞或符號。隨著AI推論需求激增,token生成速度與成本已成為衡量AI運算效能與經濟價值的核心指標,反映資料中心在能源效率、系統架構與演算法優化間的綜合競爭力。

InferenceMAX v1 由產業研究機構SemiAnalysis發布,是首個在真實應用場景中評估總運算成本的獨立基準。NVIDIA超大規模與高效能運算副總裁Ian Buck指出,推論是AI每天創造價值的關鍵,這份結果證明NVIDIA的全端架構能同時兼顧效能與效率,協助客戶在大規模AI部署下仍保持經濟效益。該測試於多個熱門模型上運行,證明現代AI已不僅追求速度,更重視經濟規模與能源利用率。

隨著生成式AI模型逐步進化至多步推理與工具整合,每次查詢所產生的詞元數急劇增加,也使推論效能與成本控制成為業界焦點。NVIDIA與OpenAI(gpt-oss 120B)、Meta(Llama 3 70B)及DeepSeek AI(DeepSeek R1)等開源團隊合作,確保最新模型能針對全球最大規模的AI推論基礎設施最佳化,展現其對開放生態系的長期承諾與技術主導地位。

在軟體層面,NVIDIA持續以「硬體與軟體協同設計」推升效能。gpt-oss-120B模型在搭載 TensorRT-LLM 函式庫 的DGX Blackwell B200系統上,展現業界領先的推論表現。TensorRT-LLM v1.0的推出,更推動大型AI模型在反應速度與吞吐量上的重大突破。藉由 NVLink Switch 1,800 GB/s 雙向頻寬,NVIDIA成功讓gpt-oss-120B效能再提升數倍,而新版本gpt-oss-120b-Eagle3-v2導入「推測式解碼(speculative decoding)」技術,使每使用者輸送量提升三倍,達到每秒100詞元的處理速度。

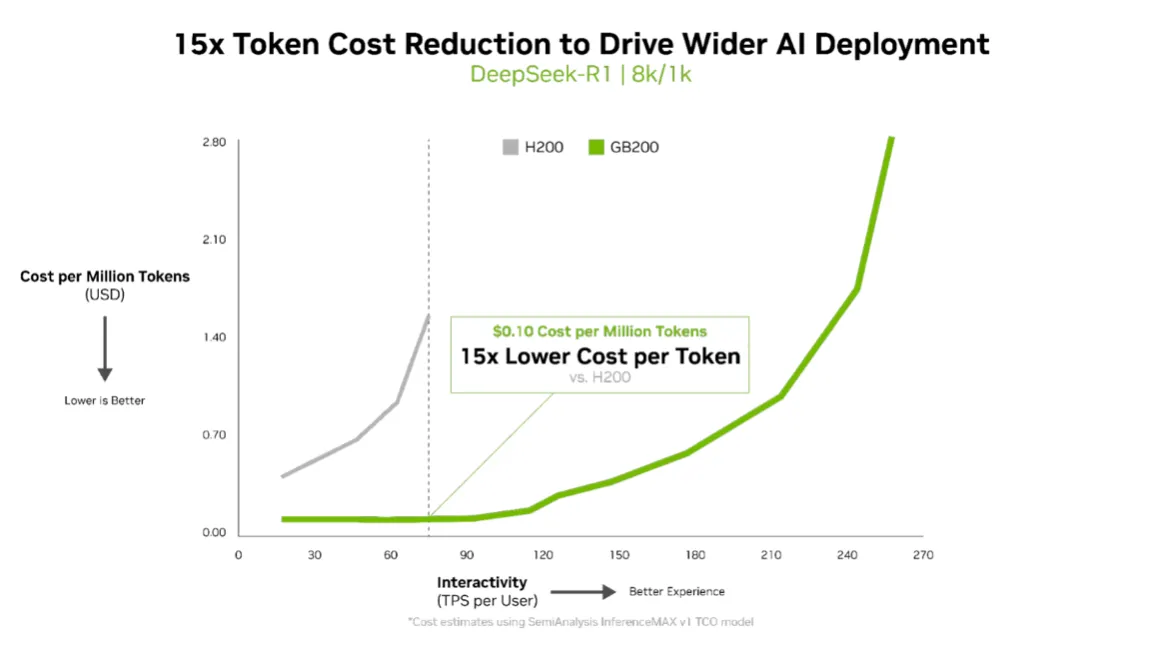

針對Llama 3.3 70B等大型模型,NVIDIA Blackwell B200在InferenceMAX v1測試中再創新標準。每GPU可達10,000 TPS(每秒交易量),每使用者達50 TPS的互動性能,比上一代H200提升四倍輸送量。對於功率受限的AI工廠而言,Blackwell架構每兆瓦輸送量較上一代提升十倍,每百萬詞元成本降低十五倍,充分展現推論經濟性的躍進。

InferenceMAX採用帕雷托前沿(Pareto frontier)分析法,評估資料中心在輸送量、能源效率與回應性間的最佳平衡。這不僅是一項效能數據展示,更代表NVIDIA Blackwell在真實生產環境中能同時實現高效能與高投資報酬率。

NVIDIA指出,Blackwell架構整合 NVFP4低精度格式、第五代NVLink並行連結 與多項開源推論框架,打造為速度、效率與規模而生的全端平台。自發表以來,僅透過軟體更新便已讓效能翻倍以上。

隨著AI從試點走向AI工廠時代,InferenceMAX v1的出現,協助企業在「每詞元成本」「延遲性服務水準協議」與「動態工作負載」之間找到最優配置。NVIDIA強調,透過 Think SMART 架構,企業能將效能直接轉化為收益,實現推論投資最大化,開啟AI經濟效益的新紀元。

點擊閱讀下一則新聞

點擊閱讀下一則新聞